Angriff auf die Demokratie

Künstliche Intelligenz bedroht Wahlen, indem sie mit personalisierter Propaganda und manipulierter Reichweite die Willensbildung untergräbt.

Künstliche Intelligenz (KI) gefährdet die Integrität demokratischer Wahlen, indem sie durch personalisierte Propaganda, durch die Erosion des Informationsvertrauens und durch Manipulation digitaler Reichweite die Grundlagen der demokratischen Willensbildung systematisch untergräbt. Die AI-Democracy Initiative analysierte zuletzt den Einfluss von KI auf Wahlen in sechs Ländern. Die Studie zeigt, dass zwar kein einzelnes disruptives KI-generiertes Desinformationsereignis eine Wahl maßgeblich beeinflusst hat, dass KI jedoch die Dynamiken und Möglichkeiten im digitalen Raum grundlegend verändert.

Grundlagen der demokratischen Willensbildung systematisch untergräbt. Die AI-Democracy Initiative analysierte zuletzt den Einfluss von KI auf Wahlen in sechs Ländern. Die Studie zeigt, dass zwar kein einzelnes disruptives KI-generiertes Desinformationsereignis eine Wahl maßgeblich beeinflusst hat, dass KI jedoch die Dynamiken und Möglichkeiten im digitalen Raum grundlegend verändert.

Diese Veränderungen sind besonders besorgniserregend, da sie nicht nur die Integrität einzelner Wahlen gefährden, sondern langfristig auch das Vertrauen in Medien, Politik und Informationen untergraben könnten. Für die EU und Deutschland besteht die dringende Herausforderung darin, die durch KI angreifbaren demokratischen Prozesse effektiv zu schützen. Die zunehmende Präsenz von KI im politischen Raum birgt erhebliche Risiken für demokratische Prozesse. Drei zentrale Gefahren sind dabei besonders hervorzuheben:

Erstens ermöglicht KI sehr leicht die Massenproduktion von überzeugender Propaganda. Im Gegensatz zu klassischen Desinformationskampagnen können mit KI sehr schnell personalisierte Inhalte erstellt werden, die gezielt auf die individuellen Ängste und Hoffnungen einzelner Wählergruppen ausgerichtet sind. Vor allem das Teilen dieser KI-Propaganda über soziale Medien in Form von Memes, ist weltweit zu beobachten. Memes sind humorvolle, oft bildbasierte Inhalte, die sich viral im Internet verbreiten und kulturelle Trends, Insiderwitze oder gesellschaftliche Phänomene aufgreifen. Diese Art der Inhaltsmanipulation ist besonders effektiv, da sie emotionale Reaktionen hervorruft, auch wenn der Verstand den künstlichen Ursprung erkennt. Vor diesem Hintergrund wird deutlich, dass eine Kennzeichnung von KI-generierten Inhalten zwar wichtig ist, aber gegen die emotionale Wirkung von KI-Propaganda nicht wirklich hilft.

Immer mehr Inhalte, die wir online sehen, sind manipuliert, oft sogar vollständig KI-generiert – Tendenz steigend.

Ein zweites, tiefer liegendes Problem ist die systematische Erosion des Vertrauens in unseren Informationsraum. Immer mehr Inhalte, die wir online sehen, sind manipuliert, oft sogar vollständig KI-generiert – Tendenz steigend. Wenn KI-generierte Inhalte und Deepfakes, allgegenwärtig werden, dann schwindet das Vertrauen darin, was authentisch ist und was nicht. Deepfakes revolutionieren die Wahrnehmungsmanipulation, untergraben das Vertrauen in authentische Inhalte und führen zu einem wachsenden Zynismus, der auch als „Realitätskrise“ bezeichnet werden kann. Diese untergräbt den demokratischen Diskurs grundlegend: Ohne gemeinsame Faktenbasis wird eine konstruktive politische Auseinandersetzung unmöglich. Die Gefahr besteht nicht nur in einzelnen Falschinformationen, sondern in einem generellen Vertrauensverlust in jegliche politische Kommunikation.

Drittens kann man Deepfakes nicht ohne den Einfluss sozialer Medien betrachten. Denn diese Plattformen dienen als mächtige Verbreitungsvektoren, die Millionen von Nutzern erreichen. Zudem ermöglichen sie die künstliche Erzeugung von Sichtbarkeit und Reichweite. Verschiedene Akteure nutzen gezielt Guerilla-Taktiken, um koordinierte Kampagnen zu lancieren und Narrative in der gesellschaftlichen Mitte zu verankern. Was dafür nötig ist? Plattformkompetenz und Zugang zur digitalen Infrastruktur – von Bots und Fake-Accounts bis hin zu Influencern. Durch die künstliche Verstärkung bestimmter Positionen können öffentliche Debatten verzerrt und das Wahlverhalten kann über einen längeren Zeitraum beeinflusst werden. Besonders besorgniserregend: Die Grenze zwischen echter Bürgerbeteiligung und orchestrierter KI-Kampagne wird zunehmend schwerer erkennbar.

Verschiedene Akteure nutzen gezielt Guerilla-Taktiken, um koordinierte Kampagnen zu lancieren und Narrative in der gesellschaftlichen Mitte zu verankern.

Diese technologische Entwicklung wirft fundamentale Fragen auf: Wenn KI-generierte Inhalte nicht mehr von menschlich erstellten unterscheidbar sind, scheint technische Regulierung allein keine ausreichende Lösung zu sein. Doch statt in digitalen Defätismus zu verfallen, muss der Fokus auf der Stärkung der demokratischen Resilienz liegen. Die Antwort liegt nicht im Versuch, jeden einzelnen Deepfake zu identifizieren, sondern in der Entwicklung einer kritischen digitalen Öffentlichkeit und robuster demokratischer Institutionen. Ähnlich wie bei klassischen Medien ist nicht die technische Authentifizierung jedes Inhalts entscheidend, sondern die Etablierung vertrauenswürdiger Informationsquellen und transparenter Kommunikationsstrukturen.

Angesichts dieser fundamentalen Bedrohungen für die demokratische Willensbildung sind entschiedene Gegenmaßnahmen erforderlich: Um die positiven Potenziale von KI systematisch zu nutzen, sollten staatliche Institutionen und Parteien gemeinsam eine digitale Infrastruktur für Bürgerbeteiligung aufbauen. Zentral wäre die Entwicklung KI-gestützter Dialogplattformen, die verschiedene Perspektiven zusammenführen und einen konstruktiven Austausch zwischen Politik und Bürgern ermöglichen. Erfolgreiche Beispiele wie der „Wahl Chat“ zur Bundestagswahl zeigen, wie KI-Tools die politische Partizipation und Informiertheit der Wählerschaft stärken können.

Das bereits vereinbarte Fairnessabkommen der Parteien zur KI-Nutzung im Wahlkampf ist ein wichtiger erster Schritt. Seine Wirksamkeit wird jedoch davon abhängen, wie konsequent die Vereinbarungen in der Praxis umgesetzt und wie Verstöße von der demokratischen Öffentlichkeit thematisiert werden. Tatsache ist auch, dass nicht alle Parteien das Abkommen unterschrieben haben. Ergänzend sind breit angelegte Aufklärungskampagnen notwendig, die nicht nur vor Manipulationsmechanismen warnen, sondern auch die Potenziale von KI für eine informierte politische Teilhabe aufzeigen. Das Verständnis für beide Aspekte ist entscheidend für die digitale Souveränität der Wählerschaft.

Langfristig ist die Zusammenarbeit von Technologieunternehmen, Wissenschaft und Zivilgesellschaft unerlässlich. Plattformbetreiber müssen mehr Transparenz über ihre Algorithmen gewähren und Mechanismen entwickeln, die sowohl Manipulation eindämmen als auch konstruktiven politischen Dialog fördern. Die Politik ist gefordert, einen Rahmen zu schaffen, der Innovation ermöglicht und gleichzeitig demokratische Prozesse schützt. Nur durch das koordinierte Engagement aller Akteure kann KI ihr Potenzial für eine lebendige Demokratie entfalten, während gleichzeitig ihre Risiken effektiv begrenzt werden.

Die Bundestagswahl 2025 wird zeigen, ob die getroffenen Maßnahmen ausreichen, um die Integrität des demokratischen Prozesses zu schützen. Das Fairnessabkommen und die vorgeschlagenen Handlungsempfehlungen sind wichtige erste Schritte. Doch ohne das konsequente Engagement aller beteiligten Akteure – von Plattformbetreibern bis zur Zivilgesellschaft – droht die manipulative Kraft der KI unsere demokratische Willensbildung nachhaltig zu beschädigen.

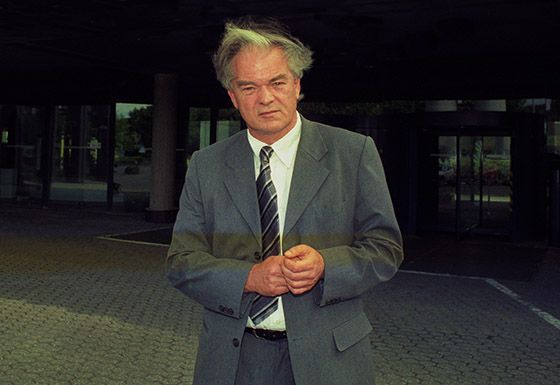

Dr. Katja Muñoz ist Research Fellow in der DGAP und forscht zu Influencern, zu Künstlicher Intelligenz und Demokratie. Sie studierte Internationalen Beziehungen und Peace and Security Studies.

Dr. Katja Muñoz ist Research Fellow in der DGAP und forscht zu Influencern, zu Künstlicher Intelligenz und Demokratie. Sie studierte Internationalen Beziehungen und Peace and Security Studies.

Emma Laumann ist Datenanalystin in der AI/Democracy Initiative der DGAP. Sie studierte Politikwissenschaft und ist Masterstudentin im Fach Sozialwissenschaften.

Emma Laumann ist Datenanalystin in der AI/Democracy Initiative der DGAP. Sie studierte Politikwissenschaft und ist Masterstudentin im Fach Sozialwissenschaften.

Schreibe einen Kommentar